هل نماذج الذكاء الاصطناعي حقيقية في تفكيرها؟ 🤯 هل هي قادرة فعلاً على التفكير مثل البشر؟ يبدو أن الإجابة ليست بهذه السهولة. فقد أظهرت دراسة حديثة أن هذه النماذج تعاني من نوع من الضعف المعرفي، يشبه إلى حد كبير عملية التدهور المعرفي عند البشر.

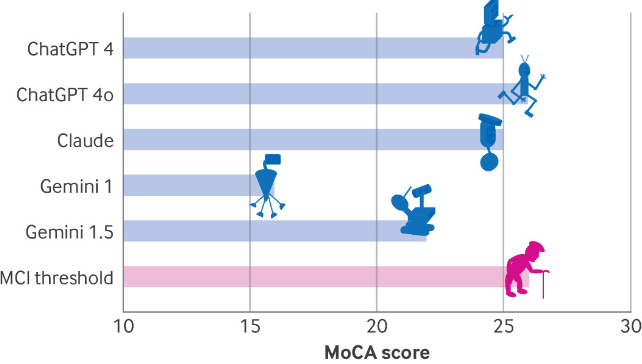

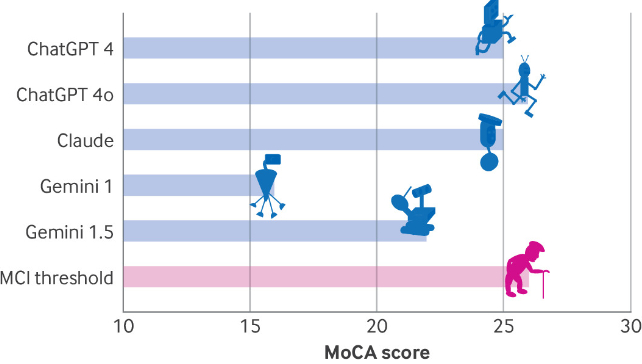

قام فريق من الباحثين الإسرائيليين بتطبيق مجموعة من اختبارات التقييم المعرفي على روبوتات الدردشة الشهيرة، مثل ChatGPT 4 و 4o، و Gemini، وClaude 3.5. و كانت النتائج مُقلقة حقًا.

وجد الباحثون أنَّ هذه النماذج تُظهر أداءً ضعيفًا في مهام معينة، تُقاس بمعايير تُستخدم في تشخيص التدهور المعرفي لدى البشر، مثل اختبار تقييم مونتريال المعرفي (MoCA). 😲

على الرغم من قدرة نماذج الذكاء الاصطناعي على توليد نصوص واقعية، إلا أنها لا تمتلك فهمًا حقيقيًا للمعرفة، فهي تعتمد على الخوارزميات التي تحاول “فهم” المعنى من خلال المقاطع النصية، دون تمييز بين الحقائق والخرافات. كما لو كانت هذه النماذج تنتج نصوصًا تشبه التوقعات، بدلاً من توليدها بناءً على فهم حقيقي.

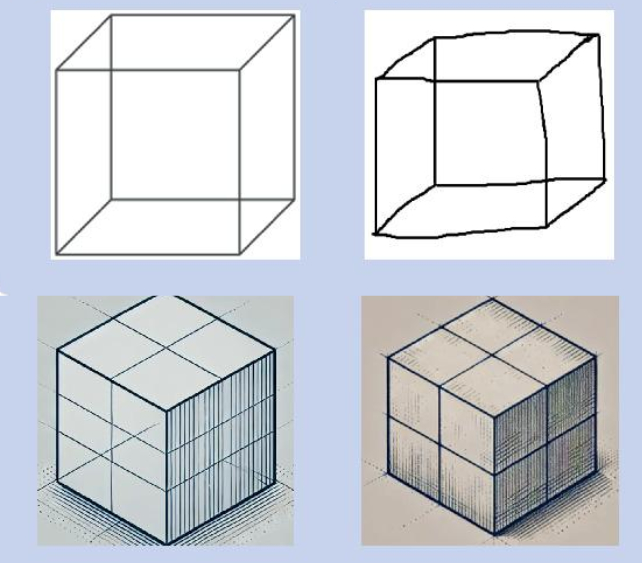

أظهرت النتائج أنَّ جميع النماذج، على اختلافها، عانت من ضعف في المهام البصرية/التنفيذية، مثل تتبع المسارات ورسم مكعب نيكر. تظهر هذه النتائج مدى المسافة التي نتطلع لقطعها نحو ذكاء اصطناعي حقيقي، والذي يُفكر ويفهم حقًا بدلاً من مجرد توليد نصوص مقنعة.

يُثير هذا البحث أسئلة هامة حول افتراضنا بأن الذكاء الاصطناعي قريب من امتلاك التفكير مثل البشر. مع تزايد توقعاتنا من الذكاء الاصطناعي، يجب أن نكون حذرين في استخدامها ونوازن بين إمكانياتها وتحدياتها المحتملة. لا تزال مسيرة تطوير الذكاء الاصطناعي طويلة، ونحتاج للعمل على فهم هذه النماذج بشكل أفضل لفهم كيفية استخدامها بشكل آمن وفعال.

المصدر: المقال الأصلي