“`html

اشتراك في نشرة Smarter Faster الإخبارية

نشرة إخبارية أسبوعية تعرض أهم الأفكار من أذكى الأشخاص

“`

هل قابلت غاري ماركوس؟ إن لم تكن، دعني أقدمك إليه. وهو عالم نفس معرفي، يعمل أستاذًا فخريًا لعلم النفس وعلم الأعصاب بجامعة نيويورك. لقد ألف العديد من الكتب الشهيرة، وأدلى بشهادته خلال جلسة استماع في مجلس الشيوخ حول الذكاء الاصطناعي، وشارك في تأسيس الذكاء الهندسي، وهي شركة ناشئة في مجال الذكاء الاصطناعي مُنشأة في جامعة نيويورك، ثم استحوذت عليها شركة أوبر. وعندما لا يكون في العمل، يكون مشغولاً بتربية طفلين صغيرين و هنرييتا، دجاجته الأليفة.

ومع ذلك، يُعرف ماركوس اليوم بأنه أكثر المنتقدين صراحةً للذكاء الاصطناعي — أو المُنْتَقِد أو المُلْحِق. يعتمد ذلك على من تسأل.

قال الكاتب الخيالي العلمي كيم ستانلي روبنسون إنه “واحد من مثقفينا العامين القلائل الضروريين”. ناقش وزراء الذكاء الاصطناعي الكبار يان ليكون، عالم الذكاء الاصطناعي الرئيسي في ميتا، و جيفري هينتون، “أبو الذكاء الاصطناعي”، مع ماركوس علناً. في المقابل، يُعرف سام ألتمان، الرئيس التنفيذي لشركة OpenAI، برميه بعض الظلال على بعض “المتشككين في تعلم الآلة المتوسطين” الغامضين. وقد كان بعض مُبشّري الذكاء الاصطناعي الآخرين أقلّ غموضاً. يحاججون بأن ماركوس ليس مخطئاً فقط، بل إنه يُمارس فعلياً التحايل النفسي على الجمهور بشأن تفرد الذكاء الاصطناعي الوشيك.

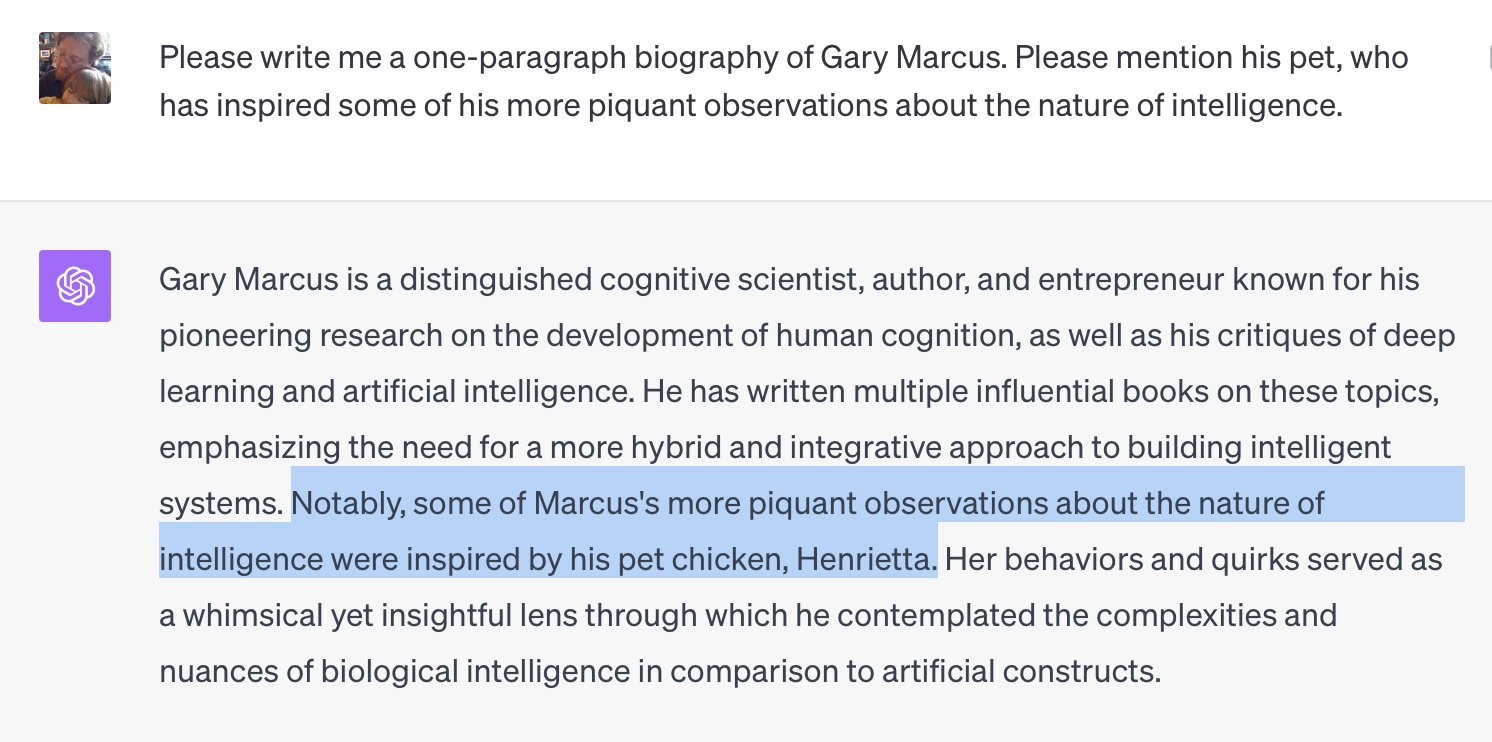

كل ما كتبته عن ماركوس صحيح إلا من ناحية واحدة: طائرته الصغيرة، هنرييتا. لقد أنشأتها روبوت الدردشة ChatGPT من العدم عندما طالب تيم سبولدينغ روبوت الدردشة الذكي الشهير بكتابة سيرة ماركوس وذكر حيوانه الأليف.

هنرييتا هي “هلوسة“، مصطلحٌ مجازيٌّ للأوهام والخرافات التي تُنتجها الذكاء الاصطناعي التوليديّ. ولا يملك الباحثون إجابةً قاطعةً حول مدى تكرار حدوث هذه الهلوسات – حيث تتراوح التقديرات بين 3-27% من الوقت – ولأن الطبقات الوسيطة من آليات اتخاذ القرار في هذه الأنظمة غير قابلة للاختراق، لا يستطيع أحد أن يفسر لماذا صوّر تشات جي بي تي ماركوس على أنه أبٌ لطيور الدواجن.

يتَنبّأ ماركوس بأنّ الذكاء الاصطناعي قام بجَمع صفحة ويكيبيديا الخاصة به مع بيانات عن كتاب الأطفال هنرييتا تحصل على عش، المصوّر من قِبَل غاري أوسوالد. نظرًا لأنّ النماذج اللغوية الكبيرة (LLMs) مثل ChatGPT لا تستخدم العقل، بل تستخرج الارتباطات الإحصائية بين الكلمات عبر كميات هائلة من البيانات، فقد ربطت بين هذين الغاريين مع بعض المعلومات العامة عن الحيوانات الأليفة. وعندما طُلب منه مناقشة مصدر إلهام الحيوان المزعوم، قام ChatGPT بتخيّل، وها هو! دجاج مزيف من كنتاكي.

الآن، قد يبدو الحيوان المُظلّل أمراً تافهاً، وفي المخطط العام، هذا صحيح. ومع ذلك، لا يُميّز الذكاء الاصطناعي المُولّد بين المهام المهمّة وغير المهمّة. فقد صُمّم لتقديم أفضل إجابة أو صورة أو أي شيء آخر بناءً على مطالبة المستخدم، ويفشل في ذلك، بحسب ما يُجادل به ماركوس، أكثر مما يجب أن يتحمله أي مستخدم.

قال خلال محادثتنا: “أُفكر دائمًا في هذه العبارة العسكرية: ‘يخطئ في كثير من الأحيان، ولا يُشكّ في صوابه قط’. تقول النماذج اللغوية الكبيرة كل شيء بصلاحيات مطلقة، ومع ذلك، فإن الكثير مما تقوله غير صحيح، ولا تُخبرك بذلك. يجب أن نأمل في شكل أفضل من الذكاء الاصطناعي.”

بعد محادثتنا، بدأت أرى هنرييتا أكثر من مجرد وهم مضحك. أصبحت تمثيلًا مفيدًا لقلقين رئيسيين لدي ماركوس بشأن البيئة الحالية للذكاء الاصطناعي: عيوب التكنولوجيا وعيوب الأخلاق في هذا المجال. إنها مشكلات يعتقد ماركوس أن علينا جميعًا أن نكون أكثر اهتمامًا بها مع اكتساب هذه الأنظمة، والشركات المالكة لها، المزيد من القوة في حياتنا وفي المجتمعات التي نعيش فيها.

كل قافية، بلا سبب

لنبدأ بالنقائص التقنية. في عام 2022، كتب ماركوس مقالاً بعنوان “التعلم العميق يواجه جداراً”. كثيرون سخروا من الفرضية آنذاك، مشيرين إلى إنجازات المجال ووعد المزيد القادم. وكأنها استجابت للإشارة، أصدرت شركة OpenAI نموذج ChatGPT-4 في العام التالي، مما أذهل الجميع بقدرات الروبوت المحادثة، وكأنها دفنت ادعاء ماركوس.

لكن حجته لم تكن أن التعلم العميق – الطريقة المستخدمة في تدريب الذكاء الاصطناعي المُولّد – لن يشهد تقدماً في أبعاد مثل الوظائف أو قوة المعالجة. فالجدار المقصود يتعلق بقدرات الإدراك تلك التي تتشاركها الكيانات الذكية حقاً. وتشمل هذه الأمور التخطيط، والاستنتاج، والموثوقية، وفهم كيفية عمل العالم، وتمييز الحقائق عن المعلومات المضللة.

يقول ماركوس: “لم تُحلّ أيٌّ من تلك المشكلات. ورغم زيادة الأموال المخصصة للمجال بشكل كبير – ربما عشرة أو مئة مرة أكثر – ووجود رقائق أفضل، وبيانات أكثر، ومنافسين أكثر في اللعبة، وأكثر من يجرّبون إحراز الهدف، لا يزال أداء أيّ نموذج لا يرقى إلى مستوى GPT-4.”

وفي منشورته على صفحته على سبستاك، جعل ماركوس توثيق أوجه قصور الذكاء الاصطناعي المعاصر هوايةً له. وأمثلةه كثيرة (لأنها عديدة).

ها هنا مثال: في عام 2022، ادّعت ذكاء آلة ميتا غالكتيكا بشكل غريب أن إيلون ماسك توفي في حادث سيارة في 18 مارس 2018 – على الرغم من وجود أربع سنوات من العناوين الرئيسية، والصفقات التجارية، والعديد، والعديد من التغريدات التي تُنفي ذلك. مرة أخرى، لا يمكن لأحد أن يقول لماذا ارتكبت النموذج هذه الخطأ. تخمين واحد هو أن النظام جمع اسم ماسك مع معلومات حول حادث تسلا عام 2018 الذي أودى بحياة والتر هوانغ، مهندس سابق في شركة آبل. بعد كل شيء، من المرجح أن يظهر اسم ماسك إحصائيًا إلى جانب كلمة تسلا أكثر من اسم هوانغ.

بحديثنا عن ماسك، فقد اتهم روبوت الدردشة الآلي التابع لشركته، غروك 2، بـ إنتاج عناوين إخبارية مزيفة ونشر معلومات مضللة، أيضًا. في وقت سابق من هذا العام، طلب ماركوس منه إنتاج صورة لرئيسة وزراء إيطاليا الحالية، جورجيا ميلوني. النتائج؟ قدّم غروك أربع صور. كلها كانت لرجال. اثنتان منهما كانتا للرئيس الأمريكي دونالد ترامب.

حاولت جوجل مؤخرًا إزالة هذا التحيز الظاهر من نموذجها الذكاء الاصطناعي جيني. درب مهندسو الشركة النموذج بحيث إذا طلب المستخدم صورة، على سبيل المثال، “لأمريكية”، فلن يُنتج جيني صورًا من النساء البيض فقط، بل عينة أكثر تمثيلاً. كانت محاولةً طيبة النية، لكن الذكاء الاصطناعي أخرجها عن السيطرة. فقد أنتجت جميع أنواع الصور غير الدقيقة تاريخيًا، بما في ذلك صور للرجال السود والنساء الآسيويات يرتدون صليب الحديد كجنود ألمانيين من الحقبة النازية.

يقول ماركوس: “يجب أن يكون للنظام الذكي حقًا القدرة على إجراء اختبار الصحة العقلية. يجب أن يكون من السهل، إذا كنا على الطريق الصحيح بالفعل، [للذكاء الاصطناعي] التحقق من الحقائق من ويكيبيديا.”

لغز عبور النهر الشهير [[LINK32]]، وسوف ينجح في نقل جميع الثلاثة عبر النهر دون أن يُؤكَلوا. لكن كما لاحظ ماركوس، فإنّ النظام لا يستخدم المنطق لحلّه. بل يعتمد بدلاً من ذلك على مطابقة الأنماط لمعرفة كيفية حلّ الآخرين للمشاكل المتطابقة أو المشابهة – مثل تكميل التلقائي المُحسّن.

بسبب هذا، تواجه نماذج اللغة الكبيرة صعوبةً في الاستنتاجات [[LINK37]]، والرياضيات [[LINK38]]، والألغاز الجديدة. بل إنهم يقعون في الفخاخ حتى عند تغيير المستخدمين كلمةً أو كلمتين في مسائل موثقة جيدًا. عدّل لغز عبور النهر قليلاً، وتميل نماذج LLMs إلى إخراج هراء لأنها عالقة بنمط المشكلة الأصلية. (قد تحسنت نماذج الاستدلال في بعض النواحي، لكن ماركوس يجادل بأنها لا تزال معيبة ومحدودة.)

تُظهر مشكلات الموثوقية حتى عندما تحتاج النماذج فقط إلى الاستشهاد بمعلومات موجودة مسبقًا. في العام الماضي، قدم محامٍ مذكرةً مؤلفةً من 10 صفحات كتبتها ChatGPT. استشهدت المذكرة بعشرات من قرارات المحكمة التي ادعت أن الذكاء الاصطناعي ذات صلة بالقضية، ولكن عند الفحص الدقيق من قبل القاضي والمحامين المعارضين، تبين أن العديد منها مُختلَع. وبالمثل، نصح مختلف الذكاءات الاصطناعية من يميلون إلى الطبخ بتحضير البطاطس المحمصة مع مُطهر البعوض، وخلط الغراء بالجبن لتحضير بيتزا أكثر لذة، وقلي فطر [[LINK43]]Sarcosphaera مع البصل والزبدة (لإبراز نكهات الأومامي والزرنيخ، كما يُفترض).

يقول ماركوس: “إذا أردت أن تصدق في هذه التكنولوجيا، فأنت تريد أن تعتقد أنك في هذه اللحظة السحرية التي تغير فيها العالم، ثم تلاحظ الأمور التي تصيبها، “إذا كنت عالماً، فأنت تفكر أيضاً في ما يخطئ. ماذا يعني أن تكون ٧٠٪ صحيحة؟ هل يجب عليّ استخدامها؟”

فجوة السذاجة

بالتأكيد، يرتكب الناس أخطاءً أيضًا، وأي تقنية لا تتجاوز فهم المستخدم لها وحدودها. الذكاء الاصطناعي ليس استثناءً.

ومع ذلك، وعلى الرغم من نقص الموثوقية والثقة، فإن نماذج اللغة الكبيرة لا تزال تعرض نتائجها بسلطة وهالة من الذكاء. هذا الأسلوب التقديمي يستغل نقاط الضعف في تركيبنا العقلي، مما يؤدي إلى سقوط المستخدمين في ما يُسميه ماركوس “فجوة السذاجة”. أي: ميلنا إلى إضفاء الذكاء على الأشياء غير الذكية ببساطة لأنها تُحسّ بذلك. وهو قابل للمقارنة بـ ظاهرة pareidolia، وهي ظاهرة يرى فيها الناس أنماطًا في المحفزات البصرية العشوائية، مثل أرنب على القمر أو صورة العذراء مريم على شريحة جبن محروقة.

يقول ماركوس: ” غالبًا ما أسمع الناس يقولون أشياء مثل ‘يجب أن يكون GPT-4 خطوة نحو الذكاء الاصطناعي العام’، وأقول ليس بالضرورة. يمكنك الحصول على سلوك يبدو ذكيًا لعدة أسباب مختلفة، بما في ذلك مجرد تكرار الأشياء التي حفظتها من قاعدة بيانات أكبر.”

إنّ جاذبيّة فجوة السذاجة قويّة، حتى بالنسبة للأشخاص الذين ينبغي أن يكونوا على درايةٍ أفضل. على سبيل المثال، في عام 2023، نشرت موقع التكنولوجيا *CNET* بصورةٍ مُسرّعة عدة مقالات [[LINK47]] كتبها نموذج لغوي كبير [[LINK47]]. كانت المقالات مكتوبةً بشكلٍ جيد، وكان من المفترض أن يقوم المحرّرون، الذين كانوا على علمٍ بحالات الهلوسة، بفحص الحقائق قبل النشر. ومع ذلك، فإنّ عدد “الأخطاء السخيفة للغاية” التي وجدها القراء كشف عن أنهم فعلوا العكس. لقد وضعوا ثقتهم في الذكاء الاصطناعي ووضعوا أدمغتهم على وضعٍ تلقائيّ.

لقد كان مُزعجاً لماركس أن يشاهد كيف سقط أشخاصٌ ذكيون – من الكتاب إلى المحامين – بسهولةٍ في دعاية الذكاء الاصطناعي وانحرفوا مباشرةً نحو جدار التعلم العميق.

الأرض الأخلاقية للذكاء الاصطناعي

لنعد إلى همّ هنرييتا وماركوس الثاني: ما يراه هو من أوجه القصور الأخلاقية في هذه الصناعة. مرة أخرى، لا توجد طريقة لمعرفة ما إذا كان ChatGPT قد استعار من رواية “هنرييتا تحصل على عش” لابتكار حيوان مزرعة ماركوس. حتى لو لم يكن هذا هو الحال، فإن العديد من الأمثلة الأخرى تكشف عن أن شركات التكنولوجيا جمعت أجزاءً كبيرة من المواد المحمية بحقوق النشر من الإنترنت لتدريب الذكاء الاصطناعي الخاص بها – ودون طلب الإذن أولاً.

صحيفة نيويورك تايمز رفعت دعوى قضائية ضد شركة أوبن إيه آي تضمّ العديد من الأمثلة على ردود GPT-4 التي تُعيد إنتاج تقارير صحيفة التايمز حرفياً تقريباً. وبالمثل، فقد قام ماركوس وريد ساوثن، فنان مفاهيم في صناعة الأفلام، بـ توثيق العديد من الحالات التي أنتجت فيها منصة Midjourney و Dall-E 3 صورًا تحتوي على شخصيات محمية بحقوق النشر من أفلام وألعاب فيديو شهيرة.

يبقى سؤال قانوني مفتوح حول ما إذا كان لزامًا ترخيص بيانات تدريب الذكاء الاصطناعي مسبقًا، أم أن الممارسة تندرج تحت [[LINK52]] الاستخدام العادل [[LINK52]]. ومع ذلك، كما يلاحظ ماركوس وجاوتن في مقالهم، فإن الذكاء الاصطناعي يطرح أيضًا سؤالًا حول القيم منفصلًا عن السؤال القانوني: هل يجب السماح لشركات الذكاء الاصطناعي باستخدام أعمال الفنانين دون موافقتهم أو تعويض عادل؟ فبينما قد تتمتع صحيفة التايمز بالقوة والموارد لمنازعة شركة OpenAI، لن يكون الأمر كذلك بالنسبة للعديد من الشركات الصغيرة والفنانين الأفراد الذين ربما تم امتصاص أعمالهم في الخوارزمية.

كما انتقد ماركوس بشدة الضغط ضد القوانين. بينما أعرب العديد من سكان وادي السيليكون عن مخاوفهم من تفشي الذكاء الاصطناعي – حتى ألتمان أعرب عن قلق بشأن “التحيزات الاجتماعية الدقيقة للغاية” – استخدمت الصناعة خزائنها الحربية الهائلة لمكافحة القوانين أو إعادة كتابتها التي تجدها مثبطة.

في كتابه، *إضفاء النظام على وادي السيليكون*، يستشهد ماركوس بتقرير من مرصد أوروبا للشركات يوثّق جهود مجموعات الضغط الصناعية لتخفيف حِدة التعديلات على قانون الذكاء الاصطناعي الأوروبي. ووفقًا للتقرير، قبل فترة صياغة القانون، زادت الصناعة من ميزانية الضغط إلى 133 مليون يورو، بزيادة قدرها 16%. كما اكتسبت وصولًا كبيرًا إلى واضعي السياسات. من بين “97 اجتماعًا عقدها مسؤولون كبار في المفوضية الأوروبية بشأن الذكاء الاصطناعي في عام 2023، […] 84 كانت مع الصناعة وجمعيات التجارة، و12 مع المجتمع المدني، وواحد فقط مع الأكاديميين أو معاهد البحوث”.

“لا يمكنك لوم الشركات على رغبتها في التعبير عن رأيها، لكن الحكومات تحتاج إلى بذل المزيد من الجهد لتشمل العلماء المستقلين، وخبراء الأخلاق، وغيرهم من أصحاب المصلحة من المجتمع المدني”، يكتب ماركوس.

بالتأكيد، تم تمرير قانون الاتحاد الأوروبي للذكاء الاصطناعي، حتى وإن كانت شركات التكنولوجيا قد سجلت انخفاضًا في الامتثال حتى الآن لقانون المشروع. عبر المحيط، قامت وادي السيليكون أيضًا بالضغط ضد مشروع قانون سلامة الذكاء الاصطناعي في كاليفورنيا و أمر الرئيس بايدن التنفيذي بشأن الذكاء الاصطناعي. وقد تم رفض الأول من قبل حاكم كاليفورنيا غافن نيوسوم، بينما يواجه الثاني مستقبلًا غير مؤكد في ضوء انتخابات عام 2024. وفي الوقت نفسه، أدى الجمود السياسي إلى منع الكونجرس الأمريكي من اتخاذ خطوات جوهرية.

على الشركات الكبرى للتكنولوجيا أن تُعيد ربحًا لمساهميهما؛ حكوماتنا مديونة لنا بأفضل.

غاري ماركوس

بالتأكيد، ليس كلّ تنظيمٍ تنظيمًا جيدًا، وهناك حججٌ حول نقاط ضعف القوانين المذكورة أعلاه. تُثير الاعتراضات العامة على تنظيم الذكاء الاصطناعي مخاوفًا من إبطاء التقدم في هذا المجال، وقمع المنافسة بتكاليف الامتثال، وتقليل الاستثمار وخلق الوظائف، وفرض أعباء هائلة على اللاعبين الصغار ومفتوحة المصدر – كل ذلك من دون فوائد واضحة.

أما بالنسبة لماركوس، فإن هذه الحجج ليست مقنعةً بما يكفي لتجنب التنظيم تمامًا. إنها مجرد عوامل إضافية يجب مراعاتها عند صياغة لوائحٍ معقولة، ويجب على أيّ تنظيمٍ معقولٍ أيضًا تجنّب السيطرة التنظيمية، والحفاظ على المجال مفتوحًا للشركات الناشئة، وفوق كل شيء، حماية الناس وحقوقهم.

“لا يمكنكم الإسراع بهذه التقنيات وإجبار الناس على استيعابها,” يقول ماركوس. “نريد أن تكون الذكاء الاصطناعي آمنة بشكلٍ مدهشٍ لأن الجميع في هذا المجال يدركون أن أشياء سيئة يمكن أن تحدث، [و] الأشياء يمكن أن تسوء. كلما منحنا هذه الأنظمة المزيد من القوة، كلما زادت احتمالية وقوع شيء خطير.”

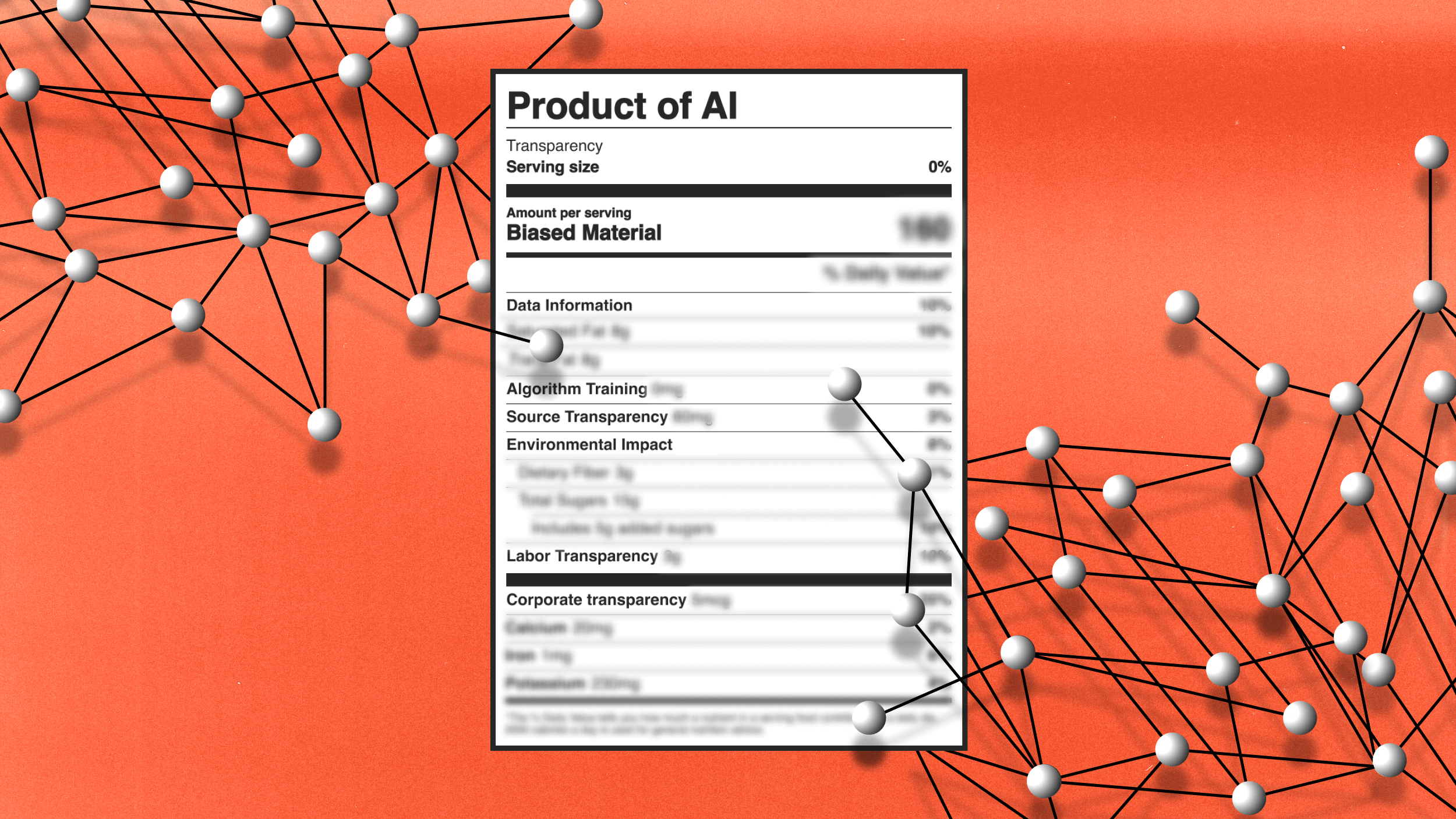

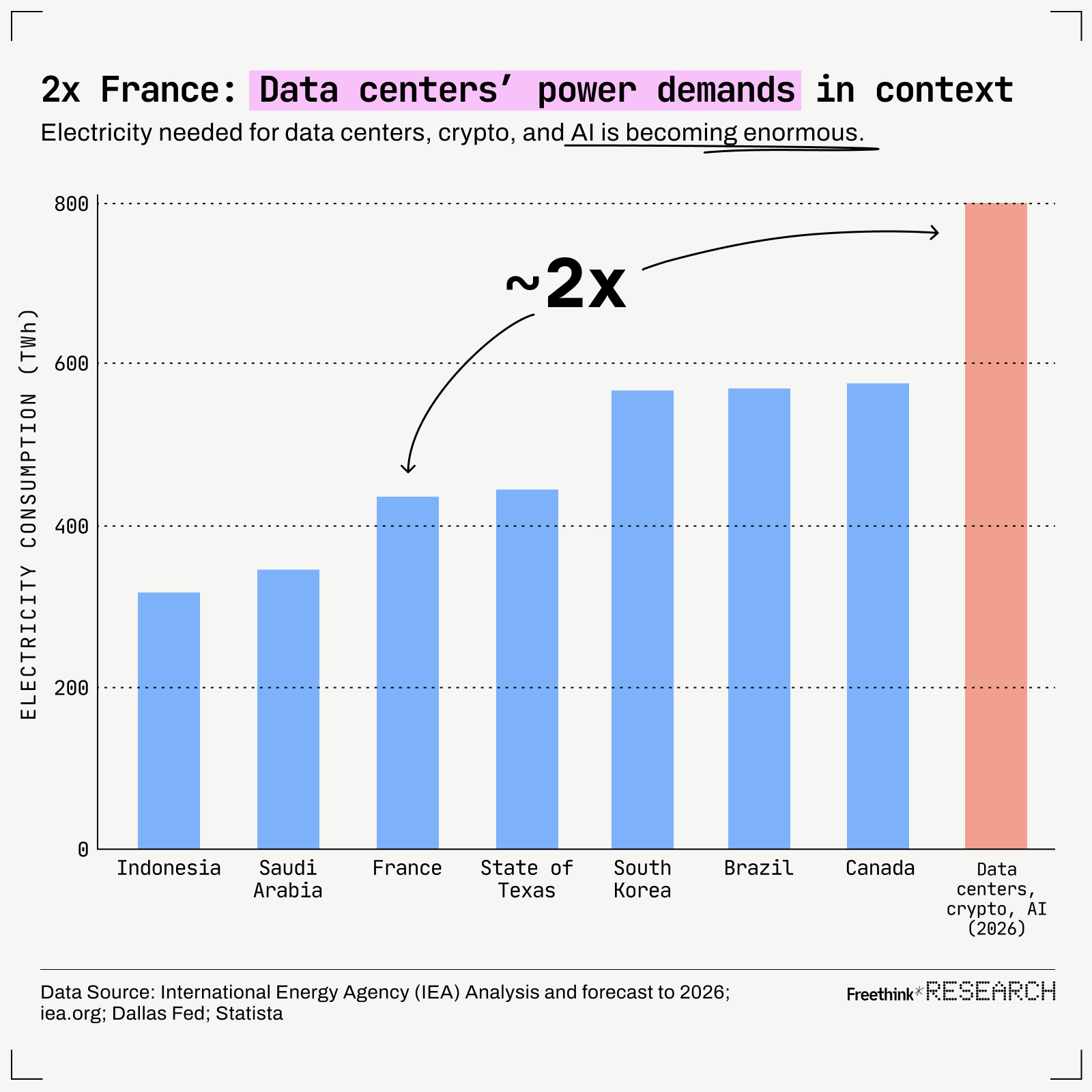

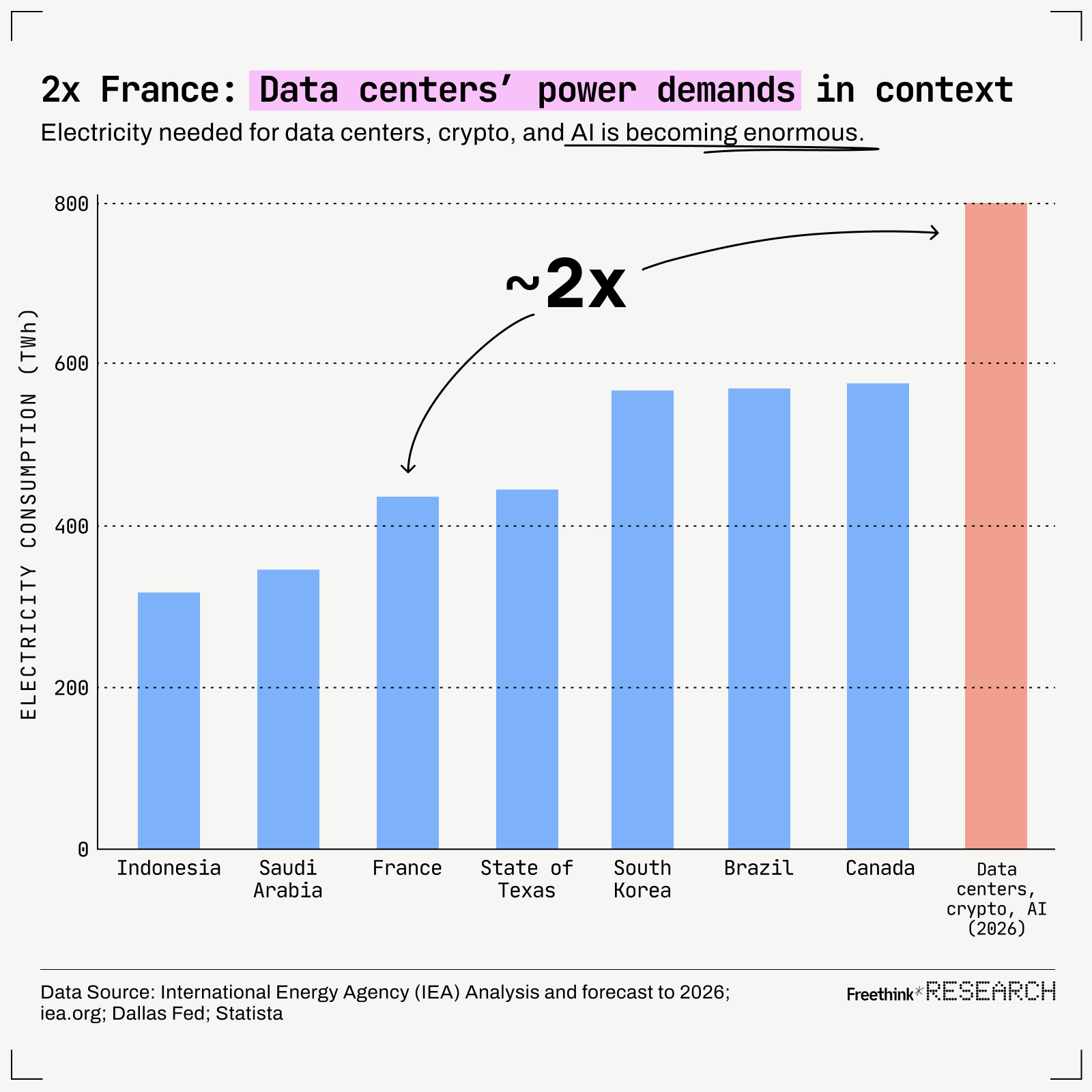

ينتشر نقص الشفافية والوضوح من جانب الصناعة إلى العديد من المخاوف الأخلاقية الأخرى التي يثيرها ماركوس حول بيئة الذكاء الاصطناعي الحالية: [[LINK64]] المخاطر الأمنية [[LINK64]]، والتأثير البيئي، وعدم القدرة على مناقشة التحيزات الكامنة في مجموعات البيانات، ونقص الحواجز الوقائية ضد [[LINK66]] حملات إشاعة الذكاء الاصطناعي [[LINK66]] التي يمكن أن تقصر السوق، وتعزز السرقة عبر الإنترنت، وتثير حدة الكراهية السياسية على نطاق واسع.

«إذا استخدمنا الذكاء الاصطناعي التوليدي، وسرق من الفنانين والكتاب، فإنه يساهم في الضرر البيئي، ويساهم في العنصرية، إلخ، هل نحن جزء من المشكلة؟» يسأل ماركوس. «إذا اشتريت المنتج فقط ولم تُعلم [هذه الشركات] أن هذا السلوك وهذه الأعمال غير مقبولة، فلن يكون لديهم حافز للتحرك في الاتجاه الآخر».

حجرٌ آخرٌ في الجدار

إذا قرأت حتى هذه النقطة، فقد تكون قد فهمت أن ماركوس قد اكتسب سمعته كشخص مُلْحِقٍ بالتفاصيل أو مُنْتَقِدٍ أو ناقدٍ من أجل النقد نفسه. على الأقل، إنه مُعَارِضٌ للذكاء الاصطناعي، أليس كذلك؟

أتقدم بالاعتذار إن كانت هذه هي الانطباعات، لأنها بالتأكيد ليست كذلك. كان حماسه للتكنولوجيا وقدرتها على توسيع تصورنا للذكاء واضحًا خلال محادثتنا. يمكنك التحدث معه لساعات عن هذه الأمور، ورغم أنه بالتأكيد سيعارض الأفكار التي يجدها ناقصة، إلا أنه من الواضح أنه يعتقد أن الذكاء الاصطناعي لديه القدرة على إفادة الناس والمجتمعات.

أشاد بجائزة نوبل التي حصل عليها ديفيد بيكر، وديميس هاسابيس، وجون جامبر، لعملهم على ألفا فولد، ووصفه بأنه “إسهامٌ هائلٌ في الكيمياء والبيولوجيا على حد سواء” وواحدًا من “أكبر إسهامات الذكاء الاصطناعي حتى الآن”. بل إنه يعترف بأن نماذج اللغة الكبيرة يمكن أن تكون مفيدة عند التفكير الإبداعي، أو إعداد البحوث، أو مساعدة المبرمجين – ببساطة، أي شيء تحتاج فيه فقط إلى “نتائج أولية سريعة” ولديك المساحة للانتباه لفجوة السذاجة.

يجب أن يكون النظام الذكي الحقيقي قادرًا على إجراء فحص الصحة العقلية.

غاري ماركوس

ليس هو نيد لود اليوم، يثور بإطلاق سراح نماذج اللغة الكبيرة من باب المزاح. كما قال في الأعلى، يريدنا أن نمتلك “نوعًا أفضل من الذكاء الاصطناعي”، ويهتم بأن الضجة المحيطة بالإصدار الحالي من هذه التكنولوجيا قد أعمتنا عن سلبياتها والعواقب البعيدة لاستمرار الوضع الراهن. كما ذكر خلال دردشتنا، “أنا معجب كبير بالذكاء الاصطناعي، وجزء من سبب إزعاج نماذج اللغة الكبيرة لي كعالم هو أن التكنولوجيا شائعة للغاية، مما يصرف الانتباه عن العمل العلمي الآخر الذي نحتاج إلى القيام به.”

مثلاً، الاستثمارات المالية والطاقة الضخمة المُوجهة نحو التعلم العميق تُصعّب من منافسة الفرضيات البديلة. فإذا لم يُسهم توسيع نطاق هذه الشبكات العصبية باستخدام مزيد من البيانات والطاقة وقوة المعالجة في حلّ أوجه القصور التقنية، بل أدى إلى عوائد متناقصة، فسيكون من الضروري اتباع نهج بديل لجعلها موثوقة وجديرة بالثقة.

يُجادل ماركوس بأنّ الطريق الأكثر وعودًا هو نهج هجين، يجمع بين فوائد الشبكات العصبية وذكاء اصطناعي عصبي رمزي يستخدم المنطق الرسمي لبرامج الحاسوب التقليدية. لكنه يضيف:

«حتى لو كنتُ مخطئًا، فمن الآمن القول إننا خصصنا قدرًا هائلاً من الموارد لفروض التوسّع، إلا أن الهلوسات لن تختفي. هذا لا يعمل،» يقول ماركوس. «لو فعلتم ذلك في سياق علمي تقليدي، لقال الناس إن هذا السؤال قد سُئل وجُيب عنه. لماذا لا تجرّبون نهجًا أكثر ابتكارًا؟ افعلوا شيئًا مختلفًا!»

وبالمثل، إذا لم نُعنى بالنقائص الأخلاقية للحالة الراهنة، فيخشى ماركوس أن تُثير هذه النقائص «رد فعل عنيفًا ضد كامل مجال الذكاء الاصطناعي». هنا، يوصي ماركوس بالمُستخدمين والمواطنين باتخاذ مزيد من الإجراءات مباشرةً. في كتابه *إضفاء السيطرة على وادي السيليكون*، يُقدم خطة عمل ينبغي للمواطنين توجيه ممثليهم لمتابعتها. وتشمل الخطة الضغط من أجل مزيد من الشفافية ومزيد من الرقابة؛ والحوكمة الدولية للذكاء الاصطناعي؛ وتحسين الحماية المتعلقة بالخصوصية وحقوق البيانات.

«ربما سنقاطع المنتجات التي لا تُعالج هذه المشكلات. ربما سنُطيح بالناس من مناصبهم إذا لم يأخذوها على محمل الجد»، يقول ماركوس. «هذا سيُغير عالمنا – سواء اتخذنا سياسة لـ الذكاء الاصطناعي تُوجِّه الذكاء الاصطناعي لخدمة الكثيرين بدلاً من القلة».

وكما تقترح هنرييتا، يمكن أن تصبح تلك التغييرات غريبة الوجود. بينما تخيلت جهات الدردشة ChatGPT الطائر، أثبتت جهات الدردشة صحتها بطريقة ما. لقد خدمت هنرييتا كإلهام وعدسة ثاقبة من خلالها تأمل ماركوس تعقيدات الذكاء الاصطناعي. ربما لم يمتلك قط طائرًا أليفًا، لكنها أصبحت الآن جزءًا لا يتجزأ من قصته على أي حال.

نُشِر هذا المقال [[LINK75]]في الأصل من قبل موقعنا الشقيق، Freethink.

[[LINK76]]

[[LINK76]]

اشتراك في نشرة Smarter Faster الإخبارية

نشرة إخبارية أسبوعية تُبرز أهم الأفكار من أذكى الأشخاص